نرخ یادگیری(Learning Rate): کلید بهینهسازی آموزش شبکههای عصبی

نرخ یادگیری تأثیر مستقیمی بر روی سرعت و کیفیت همگرایی مدل دارد و انتخاب مقدار مناسب آن میتواند تفاوت چشمگیری در عملکرد نهایی مدل ایجاد کند.

نرخ یادگیری یکی از ابرپارامترهای حیاتی در فرآیند آموزش شبکههای عصبی است که نقش مهمی در کنترل اندازه گامها در طی فرآیند بهینهسازی ایفا میکند. این پارامتر تعیین میکند که پارامترهای مدل در هر تکرار الگوریتم بهینهسازی، مانند گرادیان کاهشی تصادفی (SGD) یا نسخههای پیشرفتهتر آن، چقدر باید تغییر کنند. نرخ یادگیری تأثیر مستقیمی بر روی سرعت و کیفیت همگرایی مدل دارد و انتخاب مقدار مناسب آن میتواند تفاوت چشمگیری در عملکرد نهایی مدل ایجاد کند.

اهمیت نرخ یادگیری

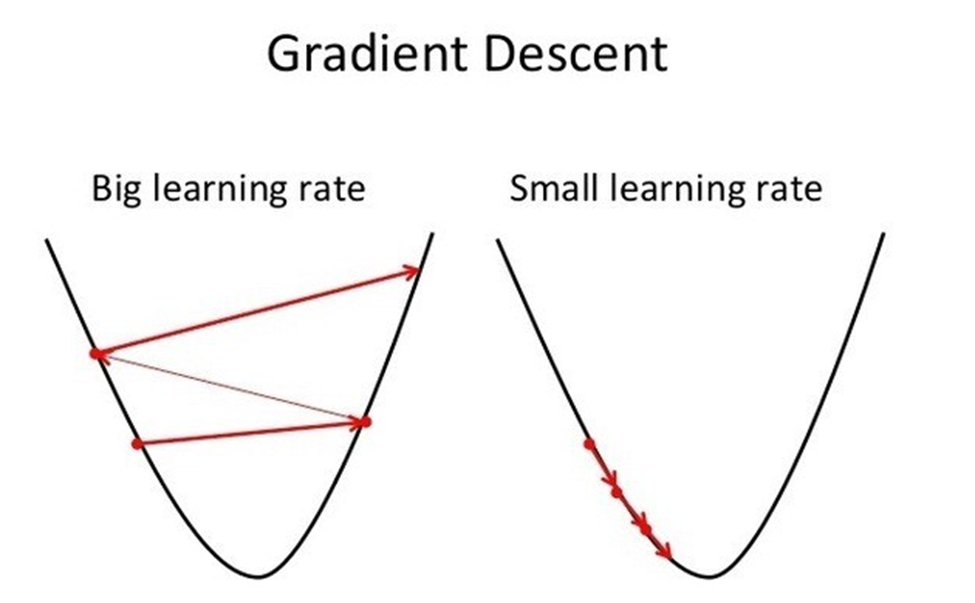

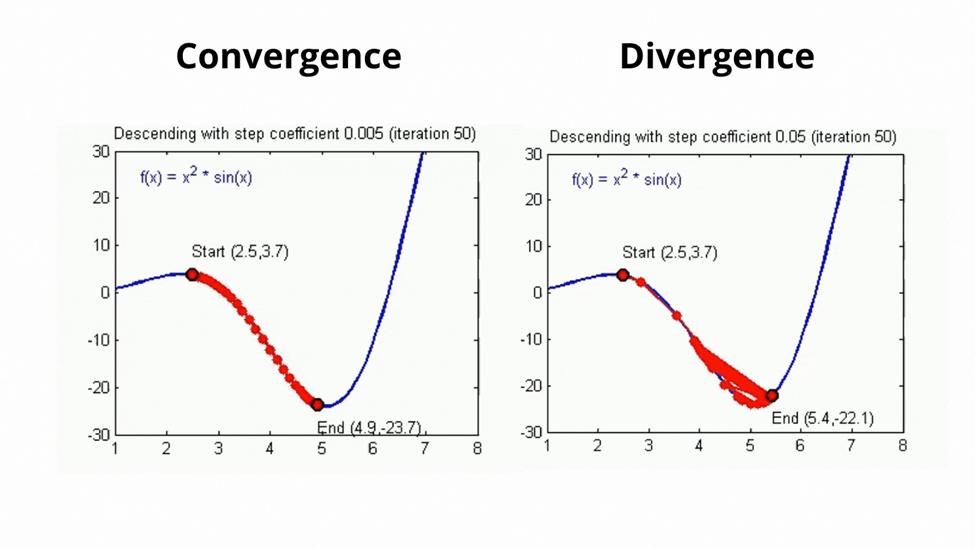

انتخاب نرخ یادگیری مناسب برای موفقیت در آموزش بسیار مهم است. نرخ یادگیری بسیار بالا میتواند باعث شود که الگوریتم بهینهسازی از حداقل تابع زیان عبور کند و منجر به آموزش ناپایدار یا حتی واگرایی مدل شود. به عبارت دیگر، نرخ یادگیری بالا میتواند باعث نوسانات شدید در مقدار تابع زیان شود و مدل نتواند به یک نقطه پایدار برسد. در مقابل، نرخ یادگیری بسیار پایین میتواند منجر به همگرایی کند شود و مدل به جای یافتن مینیمم جهانی، در کمینههای محلی گیر کند. این امر باعث میشود که مدل نتواند به دقت مطلوبی برسد.

استراتژیهای تنظیم نرخ یادگیری

در اینجا برخی از استراتژیهای رایج برای تنظیم نرخ یادگیری آمده است:

1. تنظیم دستی: یکی از روشهای ابتدایی برای تنظیم نرخ یادگیری، تنظیم دستی آن است. در این روش، با یک نرخ یادگیری متوسط شروع میکنید و بر اساس عملکرد آموزش، نرخ یادگیری را به صورت دستی تنظیم میکنید. برای این کار میتوانید نمودارهای زیان آموزش و اعتبارسنجی را مانیتور کنید و نرخ یادگیری را بر این اساس تنظیم کنید. این روش نیاز به آزمایش و تجربه دارد و ممکن است زمانبر باشد.

2. نرخ یادگیری زمانبندیشده: از زمانبندیکنندههای نرخ یادگیری برای تنظیم خودکار نرخ یادگیری در طول آموزش استفاده کنید. زمانبندیهای رایج شامل کاهش گام به گام، کاهش نمایی و نوسان کسینوسی هستند. این زمانبندیکنندهها به تدریج نرخ یادگیری را با گذشت زمان کاهش میدهند تا مدل به مرور زمان دقیقتر تنظیم شود. استفاده از این روشها میتواند باعث بهبود پایداری و کارایی آموزش شود.

3. جستجوی شبکهای یا جستجوی تصادفی: از جستجوی شبکهای یا جستجوی تصادفی بر روی دامنهای از نرخهای یادگیری برای یافتن مقدار بهینه استفاده کنید. این روش شامل آموزش چندین مدل با نرخهای یادگیری مختلف و انتخاب بهترین عملکرد بر روی یک مجموعه اعتبارسنجی است. این روش میتواند به یافتن نرخ یادگیری بهینه کمک کند، اما نیازمند منابع محاسباتی زیادی است.

4. روشهای تطبیقی نرخ یادگیری: از روشهای تطبیقی نرخ یادگیری مانند Adam، RMSProp یا Adagrad استفاده کنید. این روشها به صورت خودکار نرخ یادگیری را بر اساس گرادیانهای مشاهده شده در طول آموزش تنظیم میکنند. این روشها در بسیاری از موارد مؤثر هستند و معمولاً نیاز به تنظیم دستی کمتری نسبت به SGD سنتی دارند. استفاده از این روشها میتواند به بهبود پایداری و کارایی آموزش کمک کند.

5. بازی با مقدار نرخ یادگیری: یکی دیگر از روشهای مؤثر، بازی با مقدار نرخ یادگیری است. در این روش، آموزش را با نرخ یادگیری پایینتری شروع کنید و به تدریج آن را در مراحل اولیه آموزش افزایش دهید. بازی با مقدار نرخ یادگیری به پایداری آموزش و جلوگیری از واگرایی، به ویژه در صورت استفاده از نرخهای یادگیری بالا، کمک میکند.

عوامل مؤثر بر نرخ یادگیری

نرخ یادگیری بهینه به عواملی مانند مجموعه داده، معماری مدل و الگوریتم بهینهسازی بستگی دارد. به عنوان مثال، شبکههای عصبی عمیقتر ممکن است به نرخ یادگیری پایینتری نیاز داشته باشند تا از نوسانات شدید در طی فرآیند آموزش جلوگیری شود. همچنین، دادههای بزرگتر ممکن است نیاز به نرخ یادگیری پایینتری داشته باشند تا مدل بتواند به درستی آموزش ببیند. علاوه بر این، الگوریتمهای بهینهسازی مختلف ممکن است نیاز به تنظیمات مختلفی داشته باشند.

پیاده سازی نرخ یادگیری به کمک پایتون

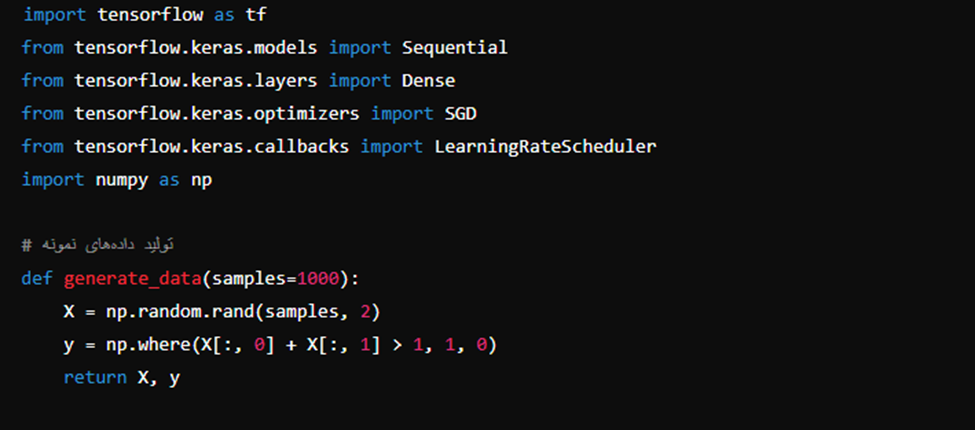

در ادامه یک کد پایتون برای پیادهسازی نرخ یادگیری و استفاده از زمانبندیکنندههای نرخ یادگیری در کتابخانه TensorFlow است. این کد شامل ایجاد یک مدل ساده، تنظیم نرخ یادگیری اولیه و استفاده از یک زمانبندیکننده نرخ یادگیری برای کاهش تدریجی نرخ یادگیری در طول آموزش است.

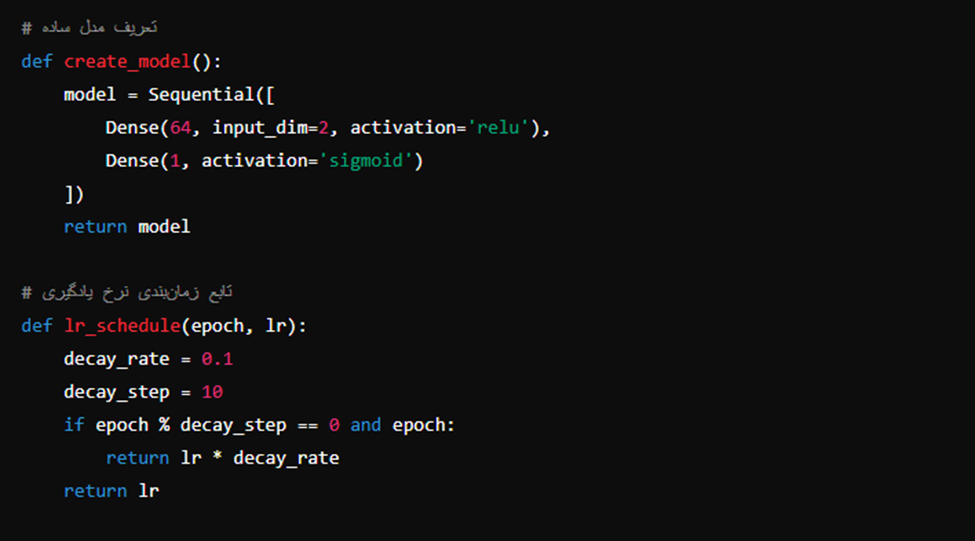

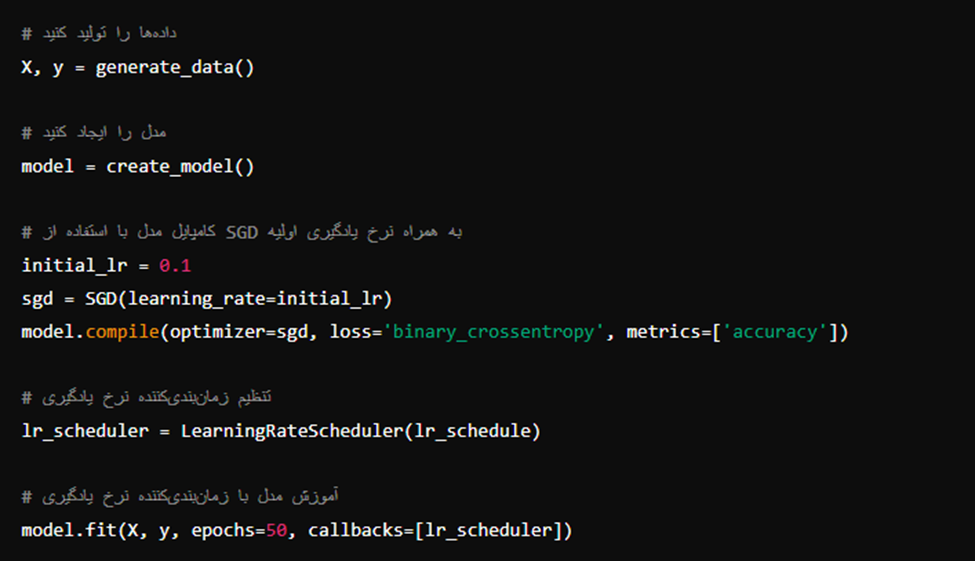

توضیحات مربوط به کد در ادامه آمده است:

تولید دادههای نمونه: تابع generate_data دادههای تصادفی ایجاد میکند که در اینجا یک مسئله طبقهبندی ساده است.

تعریف مدل ساده: یک مدل ساده با دو لایه Dense ایجاد شده است. لایه اول ۶۴ نرون با تابع فعالسازی ReLU دارد و لایه خروجی یک نرون با تابع فعالسازی سیگموئید دارد.

تابع زمانبندی نرخ یادگیری: lr_schedule تابعی است که نرخ یادگیری را بر اساس شماره ایپاک تنظیم میکند. در اینجا، نرخ یادگیری هر ۱۰ ایپاک یکبار به ۱۰ درصد مقدار قبلی کاهش مییابد.

کامپایل مدل: مدل با استفاده از بهینهساز SGD و نرخ یادگیری اولیه ۰.۱ کامپایل شده است.

تنظیم زمانبندیکننده نرخ یادگیری: LearningRateScheduler از Keras برای اعمال تابع زمانبندی نرخ یادگیری در طول آموزش استفاده میشود.

آموزش مدل: مدل با دادههای تولید شده آموزش داده میشود و زمانبندیکننده نرخ یادگیری به عنوان یک callback به تابع fit اضافه شده است.

این کد یک مثال ساده است و شما میتوانید آن را با توجه به نیازهای خاص خود تنظیم کنید.

نتیجهگیری

انتخاب نرخ یادگیری مناسب یکی از مهمترین تصمیمات در فرآیند آموزش شبکههای عصبی است. نرخ یادگیری تأثیر مستقیمی بر روی سرعت و کیفیت همگرایی مدل دارد و انتخاب مقدار مناسب آن میتواند تفاوت چشمگیری در عملکرد نهایی مدل ایجاد کند. استفاده از روشهای مختلف برای تنظیم نرخ یادگیری، مانند تنظیم دستی، نرخ یادگیری زمانبندی شده، جستجوی شبکهای یا تصادفی، روشهای تطبیقی و بازی کردن با مقدار نرخ یادگیری، میتواند به بهبود عملکرد مدل کمک کند.

در نهایت، یافتن نرخ یادگیری بهینه نیاز به آزمایش و تنظیم دقیق دارد و مانیتورینگ منظم پیشرفت آموزش و عملکرد اعتبارسنجی برای انتخاب استراتژی مناسب نرخ یادگیری ضروری است. با توجه به اهمیت این پارامتر، توجه کافی به تنظیم نرخ یادگیری میتواند به بهبود چشمگیر عملکرد مدلهای یادگیری عمیق منجر شود.

پینوشت:

انتخاب و تنظیم نرخ یادگیری یکی از چالشهای مهم در آموزش شبکههای عصبی است که نیازمند دقت و تجربه میباشد. استفاده از ابزارها و تکنیکهای مختلفی که در این مقاله مطرح شد، میتواند به شما کمک کند تا مدلهای بهتری ایجاد کنید و عملکرد آنها را بهینه کنید. اگر سوال یا تجربهای در این زمینه دارید، خوشحال میشویم که در قسمت نظرات با ما به اشتراک بگذارید.